Recherche

Vers un machine learning neuro-inspiré

La grande majorité des approches modernes en vision par ordinateur repose fortement sur l'apprentissage automatique, et notamment sur l'apprentissage profond. Depuis bientôt deux décennies, les réseaux de neurones artificiels convolutifs profonds sont devenus la méthode de référence pour de nombreuses tâches de vision : classification et détection d'objets ou d'actions, alignement de visages, etc. La disponibilité à la fois de très grandes quantités de données annotées et d'immenses ressources de calcul a permis les progrès remarquables de cette approche, mais ce succès arrive aux prix conséquents des coûts humains pour l'annotation manuelle des données et des coûts énergétiques non négligeables pour l'entrainement des CNNs profonds.

En me démarquant des approches d'apprentissage profond couramment utilisées en machine learning, je m'intéresse à un type particulier de réseaux de neurones : les réseaux de neurones impulsionnels (Spiking Neural Networks, SNN), proches du modèle biologique, dans lesquels les neurones émettent des impulsions sortantes (potentiels d'action ou spikes) de manière asynchrone, en fonction des stimulations entrantes, asynchrones elles aussi. Ce type de réseaux de neurones présente l'avantage de réaliser un apprentissage majoritairement non supervisé (ce qui limite la nécessité de données manuellement annotées) grâce aux règles d'apprentissage bio-inspirées de type Spike-Timing Dependent Plasticity (STDP).

La règle STDP met à jour les poids synaptiques en fonction des relations de cause à effet constatées entre les impulsions entrantes et sortantes. Le but de cette règle, inspirée de la loi de Hebb, est le renforcement des connexions entrantes qui sont la cause des impulsions sortantes.

L'objectif à terme est d'utiliser ces modèles de réseaux de neurones pour résoudre des tâches modernes de vision par ordinateur en contournant un des principaux écueils des méthodes actuelles. L’impact attendu est un changement de paradigme en machine learning et en vision par ordinateur, par rapport aux méthodes populaires gourmandes en données et en puissance de calcul. Les SNN présentent de nombreuses caractésitiques intéressantes pour ce changement de paradigme, telles que leur entrainement non supervisé avec les règles STDP et la possibilité de leur mise en œuvre sur du matériel neuromorphique à très faible consommation. Et pourtant, un certain nombre de défis se posent avant qu'ils ne deviennent une alternative réaliste pour faire face à la demande toujours croissante en machine learning.

Apprentissage non supervisé de patterns temporels

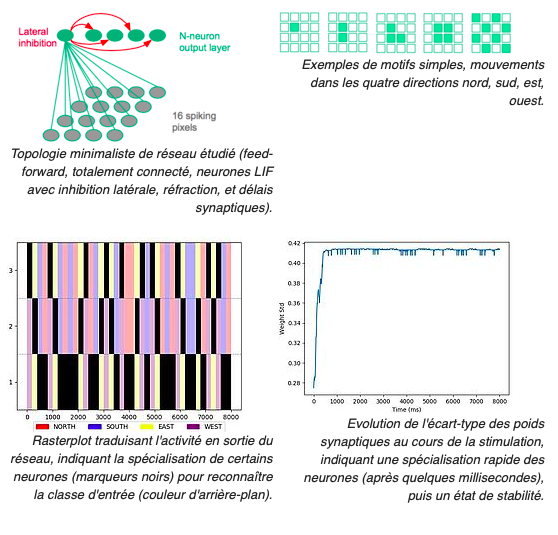

Je m'intéresse à la caractérisation du mouvement à l'aide de réseaux de neurones impulsionnels (SNN). Dans le cadre de la thèse de M. Veïs Oudjail (depuis Octobre 2018), nos premiers travaux ont visé la détection non supervisée de la direction du mouvement d'un motif.

Les premiers résultats obtenus avec les SNN ont démontré la capacité de ces réseaux à reconnaître et à caractériser les mouvements de motifs simples composés de quelques pixels (points, lignes, angles) dans une image. Nous considérons les séquences vidéos encodées au format Address-Event Representation (AER), comme celui produit par les capteurs de type Dynamic Vision Sensor. Ces capteurs se distinguent des capteurs vidéo classiques en cela qu'au lieu de produire des séquences d'images RGB ou niveau de gris échantillonnées à taux fixe, ils encodent de manière binaire les variations de luminosité positive ou négative, indépendamment pour chaque pixel. Ainsi, chaque variation d'un pixel à un instant donné se traduit par un événement correspondant transmis de manière asynchrone, avec une haute fréquence d'échantillonnage. Par ailleurs, cet encodage élimine une grande partie de la redondance dans l'information de mouvement - au prix de la perte des informations statiques de texture (constraste spatial). Ainsi, ces capteurs offrent une forme de représentation dynamique native du mouvement.

Le caractère asynchrone des SNN en fait un modèle susceptible de naturellement bien prêter au traitement de ce type de données : les événements générés par le capteur peuvent être interprétés comme des spikes pour nourrir la couche d'entrée du réseau.

La caractérisation du flux optique repose classiquement sur des traitements, opérateurs, et calculs complexes liés à la nature des capteurs physiques RGB conventionnels qui produisent des séquences d'images. Le portage bio-inspiré des traitements conventionnels en vision nécessite de repenser la manière de traiter l'information visuelle, en travaillant directement avec le contraste temporel et le mouvement. Cela laisse présager un traitement plus efficace.

Au delà de l'efficacité en termes de calculs, il est également attendu de disposer d'une information de meilleure qualité, dépourvue des bruits induits par les processus de captation et prétraitements usuels (dématriçage, compression, etc.) L'objectif est ici de proposer une chaîne de traitements bio-inspirés, du capteur au traitement de l'information visuelle.

Projet européen CHIST-ERA APROVIS3D (2020-2022)

(description originale en anglais) Analog PROcessing of bioinspired Vision Sensors for 3D reconstructionAPROVIS3D project targets analog computing for artificial intelligence in the form of Spiking Neural Networks (SNNs) on a mixed analog and digital architecture. The project includes including field programmable analog array (FPAA) and SpiNNaker applied to a stereopsis system dedicated to coastal surveillance using an aerial robot. Computer vision systems widely rely on artificial intelligence and especially neural network based machine learning, which recently gained huge visibility. The training stage for deep convolutional neural networks is both time and energy consuming. In contrast, the human brain has the ability to perform visual tasks with unrivalled computational and energy efficiency. It is believed that one major factor of this efficiency is the fact that information is vastly represented by short pulses (spikes) at analog – not discrete – times. However, computer vision algorithms using such representation still lack in practice, and its high potential is largely underexploited. Inspired from biology, the project addresses the scientific question of developing a low-power, end-to-end analog sensing and processing architecture of 3D visual scenes, running on analog devices, without a central clock and aims to validate them in real-life situations. More specifically, the project will develop new paradigms for biologically inspired vision, from sensing to processing, in order to help machines such as Unmanned Autonomous Vehicles (UAV), autonomous vehicles, or robots gain high-level understanding from visual scenes. The ambitious long-term vision of the project is to develop the next generation AI paradigm that will eventually compete with deep learning. We believe that neuromorphic computing, mainly studied in EU countries, will be a key technology in the next decade. It is therefore both a scientific and strategic challenge for the EU to foster this technological breakthrough. The consortium from four EU countries offers a unique combination of expertise that the project requires. SNNs specialists from various fields, such as visual sensors (IMSE, Spain), neural network architecture and computer vision (Uni. of Lille, France) and computational neuroscience (INT, France) will team up with robotics and automatic control specialists (NTUA, Greece), and low power integrated systems designers (ETHZ, Switzerland) to help geoinformatics researchers (UNIWA, Greece) build a demonstrator UAV for coastal surveillance (TRL5). Adding up to the shared interest regarding analog based computing and computer vision, all team members have a lot to offer given their different and complementary points of view and expertise. Key challenges of this project will be end-to-end analog system design (from sensing to AI-based control of the UAV and 3D coastal volumetric reconstruction), energy efficiency, and practical usability in real conditions. We aim to show that such a bioinspired analog design will bring large benefits in terms of power efficiency, adaptability and efficiency needed to make coastal surveillance with UAVs practical and more efficient than digital approaches.

Aide financière

L'aide financière de CHIST-ERA est 867 560 € pour 36 mois (Avril 2020-Mars 2023).Consortium

| Université Côte d'Azur Université de Lille |

France |

| Institut de Neurosciences de la Timone | France |

| Instituto de Microelectrónica de Sevilla IMSE-CNM | Spain |

| University of West Attica | Greece |

| National Technical University of Athens | Greece |

| ETH Zürich | Switzerland |

Contact

Jean Martinet, Université Côte d'AzurVoir aussi http://www.chistera.eu/projects/aprovis3d