Fusion de données Sonar et Vidéo pour la classification de fonds marins

Description

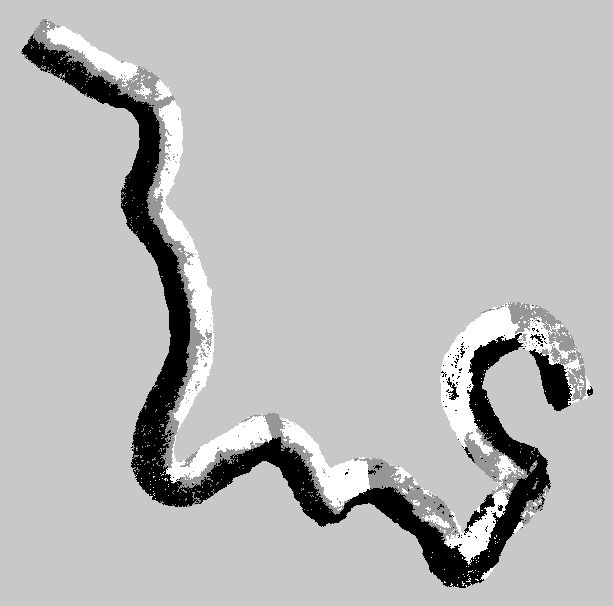

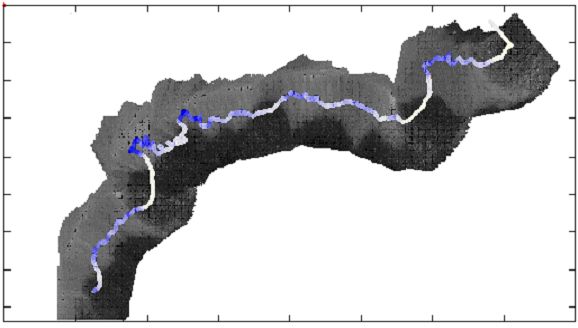

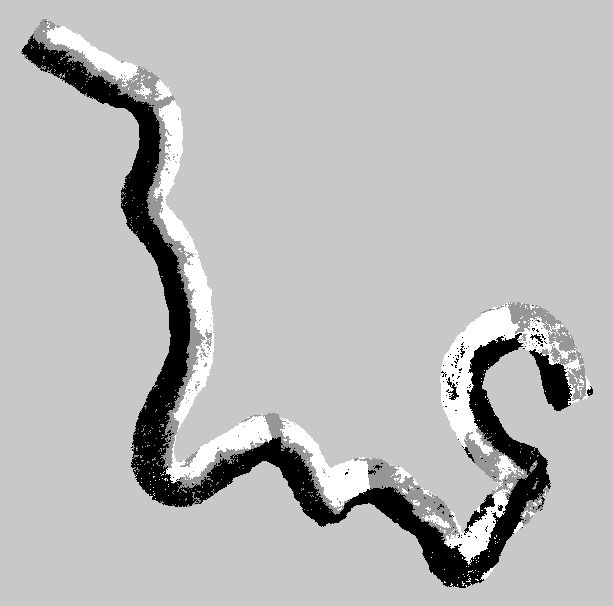

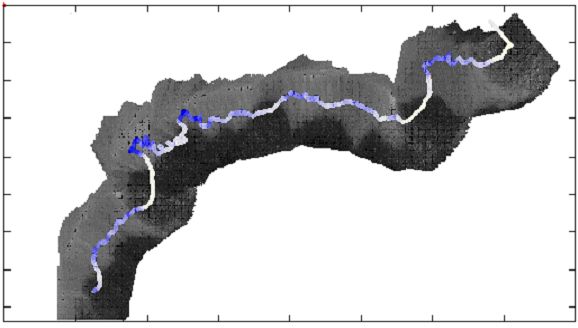

Le projet SAM (Systèmes Autonomes Mobiles) du Laboratoire I3S étudie la définition de systèmes de navigation pour des robots autonomes qui opèrent dans des milieux inconnus et non-structurés, et qui doivent construire, pendant leur opération, une carte de leur région de travail. Dans ce but, nous avons développé sur le robot Phantom des algorithmes capables d'utiliser les images acquises par une caméra vidéo [1] ou par un sonar profileur [2] pour conduire le robot automatiquement le long de contours naturels définis par les différentes types de habitats benthiques.

Le but de ce stage est de mettre en place une méthode suivi de contours basée sur la fusion des deux types de capteurs, de façon à augmenter la robustesse de l'observation des contours. Les méthodes utilisées en ce moment sont basées sur l'apprentissage non-supervisée de modèles statistiques des signaux reçus correspondants à chacune des deux régions (voisinages de l'image ou séquence de profils sonar), voire références [1] et [2]. Pendant le stage, deux approches de fusion seront considérées: l'approche centralisée, qui sera basée sur une modélisation conjointe des caractéristiques des signaux sonar et vidéo pour chacune des classes présentes, et des méthodes décentralisées, qui combinent les classifications obtenues séparemment à partir des informations acquises par le sonar et par la caméra vidéo, et qui demande une caractérisation de la confiance associée aux classifications produites par chacun des systèmes.

Le robot sous-marin Phantom est un robot téléopéré depuis la surface à l'aide d'un cable (ombilical) qui le relie à des ordinateurs à terre. Le Phantom est équipé de deux propulseurs horizontaux qui permettent son déplacement dans le plan horizontal (avant/arrière, tourner à gauche et à droite) et d'un moteur vertical qui contrôle son déplacement dans le plan vertical. Cette plate-forme est équipée de capteurs de navigation (compas trois axes, gyroscope, capteur d'immersion (pression), et de compteurs qui mesurent la vitesse de rotation des axes de ses moteurs), et de capteurs qui permettent l'observation de l'environnement: une caméra vidéo (avec pan & tilt), un sonar profileur (à balayage mécanique, monté sur une plate-forme tilt) et un altimètre (mesure de l'altitude par rapport au fond de l'océan).

Ce travail devra être réalisé à l'I3S, avec la réalisation de quelques tests en mer, à l'Observatoire Océanographique de Villefranche-sur-Mer.

Connaissances requises

L'étudiant(e) doit avoir des bonnes connaissances en Probabillités et Statistiques et en Traitement du Signal, et avoir une bonne expérience en programmation en C/C++.

Contacts

Maria-João Rendas (rendas@i3s.unice.fr), Stefan Rolfes (rolfes@i3s.unice.fr) ou Christian Barat (barat@i3s.unice.fr)

Le projet SAM (Systèmes Autonomes Mobiles) du Laboratoire I3S étudie la définition de systèmes de navigation pour des robots autonomes qui opèrent dans des milieux inconnus et non-structurés, et qui doivent construire, pendant leur opération, une carte de leur région de travail. Dans ce but, nous avons développé sur le robot Phantom des algorithmes capables d'utiliser les images acquises par une caméra vidéo [1] ou par un sonar profileur [2] pour conduire le robot automatiquement le long de contours naturels définis par les différentes types de habitats benthiques.

( Cliquer

sur les images pour voir le video de l'acquisition )

Le but de ce stage est de mettre en place une méthode suivi de contours basée sur la fusion des deux types de capteurs, de façon à augmenter la robustesse de l'observation des contours. Les méthodes utilisées en ce moment sont basées sur l'apprentissage non-supervisée de modèles statistiques des signaux reçus correspondants à chacune des deux régions (voisinages de l'image ou séquence de profils sonar), voire références [1] et [2]. Pendant le stage, deux approches de fusion seront considérées: l'approche centralisée, qui sera basée sur une modélisation conjointe des caractéristiques des signaux sonar et vidéo pour chacune des classes présentes, et des méthodes décentralisées, qui combinent les classifications obtenues séparemment à partir des informations acquises par le sonar et par la caméra vidéo, et qui demande une caractérisation de la confiance associée aux classifications produites par chacun des systèmes.

Le robot sous-marin Phantom est un robot téléopéré depuis la surface à l'aide d'un cable (ombilical) qui le relie à des ordinateurs à terre. Le Phantom est équipé de deux propulseurs horizontaux qui permettent son déplacement dans le plan horizontal (avant/arrière, tourner à gauche et à droite) et d'un moteur vertical qui contrôle son déplacement dans le plan vertical. Cette plate-forme est équipée de capteurs de navigation (compas trois axes, gyroscope, capteur d'immersion (pression), et de compteurs qui mesurent la vitesse de rotation des axes de ses moteurs), et de capteurs qui permettent l'observation de l'environnement: une caméra vidéo (avec pan & tilt), un sonar profileur (à balayage mécanique, monté sur une plate-forme tilt) et un altimètre (mesure de l'altitude par rapport au fond de l'océan).

Ce travail devra être réalisé à l'I3S, avec la réalisation de quelques tests en mer, à l'Observatoire Océanographique de Villefranche-sur-Mer.

Connaissances requises

L'étudiant(e) doit avoir des bonnes connaissances en Probabillités et Statistiques et en Traitement du Signal, et avoir une bonne expérience en programmation en C/C++.

Contacts

Maria-João Rendas (rendas@i3s.unice.fr), Stefan Rolfes (rolfes@i3s.unice.fr) ou Christian Barat (barat@i3s.unice.fr)

Références

- Image Segmentation by Unsupervised Adaptive Clustering in the Distribution Space for UAV Guidance Along Sea-bed Boundaries Using Vision, A. Tenas, M-J Rendas and J-P Folcher, Oceans'2001.

-

Using Statistical Mixture Models for Tracking Natural Underwater Boundaries, Maria João Rendas , Christian Barat , UUST 2003, New Hampshire, USA, October 2003.

- http://www.i3s.unice.fr/sports/SyncCharts/